К концу этой статьи ты поймёшь не только что такое Nginx, но и почему он появился, зачем он нужен и как используется на практике — с наглядными примерами, которые в финале всё прояснят.

Когда веб был простым

В начале развития интернета всё было довольно легко. Меньше пользователей, меньше сайтов, меньше хаоса. Браузер отправлял запрос на страницу одному веб-серверу. Этот сервер был обычной машиной, на которую ставили специальное ПО — оно собирало веб-страницу и отправляло её обратно браузеру, который показывал её пользователю.

И вот это самое ПО, которое работало на серверной машине и отвечало на запросы браузера, —

да, это и был Nginx. Серверное приложение, созданное для ответа на HTTP-запросы.

Потом веб стал популярным (и начались проблемы)

В один момент сайты стали получать не сотни запросов, а тысячи или миллионы.

Представь, что один сервер должен обработать миллионы запросов.

Нереально. Это далеко за пределами возможностей одного сервера.

Что сделали?

Добавили больше серверов. Например, десять серверов с Nginx.

Но сразу появился новый вопрос: как распределять запросы между этими серверами?

И тут на сцену выходит балансировка нагрузки.

Nginx как балансировщик нагрузки (тот самый “консьерж”)

Nginx может работать не только как веб-сервер, но и как прокси-сервер, распределяющий входящие запросы между несколькими бэкенд-серверами.

Прокси — это, по сути, “делать что-то от имени кого-то”.

Nginx принимает запросы от браузеров от лица серверов, стоящих за ним, и направляет их туда, где есть свободные ресурсы.

Как консьерж в отеле, который решает, в какой номер отправить гостя.

Как Nginx распределяет нагрузку

Зависит от выбранного алгоритма:

-

Least Connections — сервер с наименьшей загрузкой принимает запрос.

-

Round Robin — классика: каждый сервер получает запрос по очереди по кругу.

Просто — но эффективно.

На этом этапе Nginx уже умеет быть:

-

Веб-сервером,

-

Прокси / балансировщиком нагрузки.

Технология одна, задачи разные.

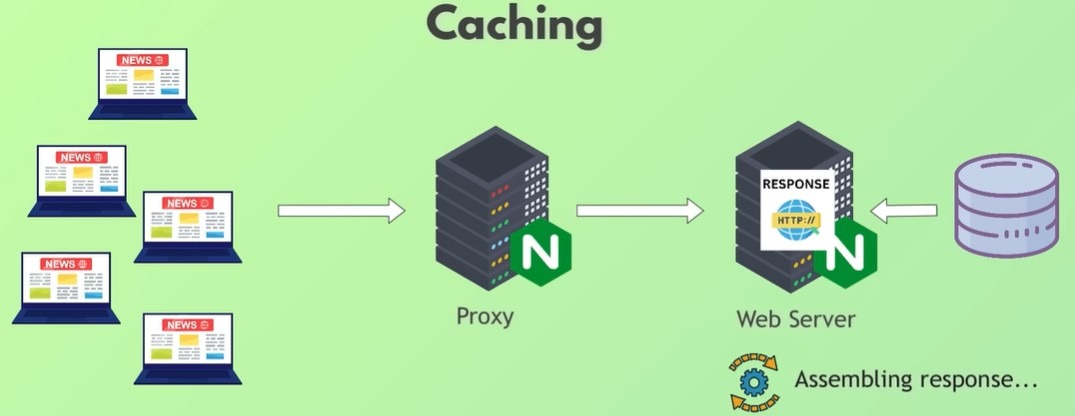

Кэширование: как обслуживать миллионы запросов и не умереть

Представь: New York Times публикует новую статью. Миллионы людей открывают её одновременно.

Если бы каждый запрос заставлял бэкенд снова:

-

тянуть картинки,

-

запрашивать базу данных,

-

собирать HTML,

-

формировать ссылки,

-

отправлять ответ…

…миллион раз — сервера бы просто рухнули.

Правильный подход?

Один раз собрать статью, сохранить окончательную версию и раздавать её всем.

Это и есть кэширование — одна из ключевых функций Nginx.

Оно спасает базу данных и сервера от постоянной нагрузки.

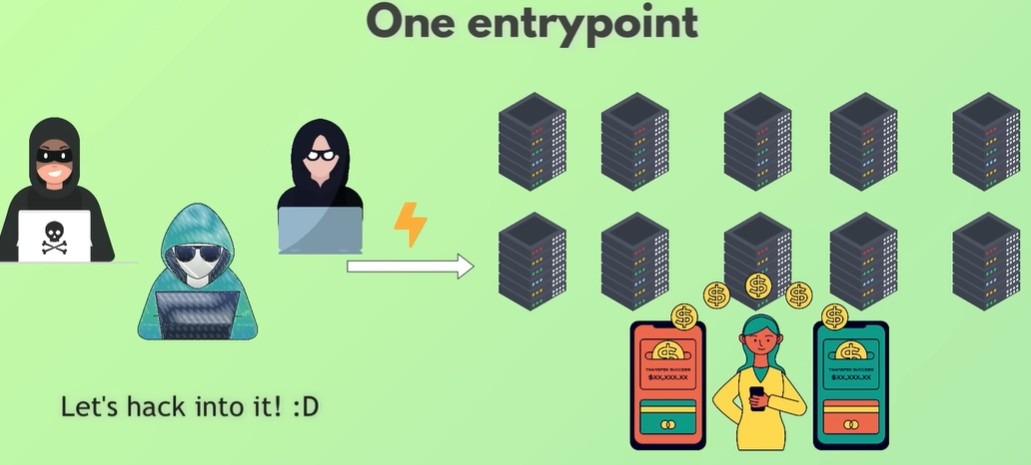

Безопасность: уменьшение поверхности атаки

Теперь представь интернет-банк или соцсеть вроде Facebook, где работает 100 серверов.

Это лакомая цель для хакеров.

Если сделать все эти 100 серверов публично доступными, всё становится очень страшно.

Хакеру нужна только одна уязвимость в одном сервере — и он проникнет во всю систему.

Решение?

Сделать публичным только Nginx-прокси и скрыть все бэкенд-серверы за ним.

Теперь защищать нужно один сервер, а не сотню.

Поверхность атаки уменьшается в разы.

Nginx превращается в щит — защитный слой между интернетом и твоей инфраструктурой.

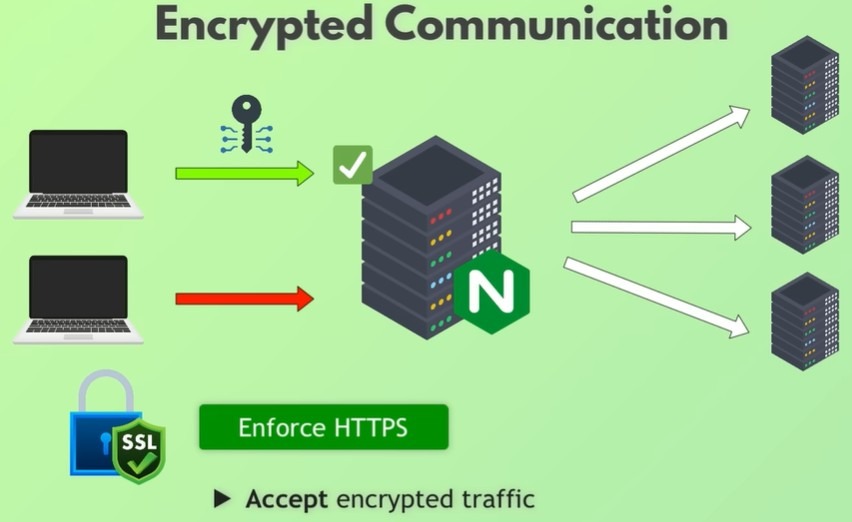

Шифрование: HTTPS и строгая безопасность

Раз у нас всего один входной сервер, мы можем заставить его принимать только зашифрованный трафик.

Браузер шлёт зашифрованные данные → Nginx принимает их.

Даже если кто-то перехватит трафик, прочитать его невозможно.

В разных системах реализация разная:

-

иногда Nginx сам расшифровывает запросы,

-

иногда он просто передаёт их зашифрованными дальше в сеть — это даже безопаснее.

Nginx легко настраивается так, чтобы полностью запрещать незашифрованный трафик.

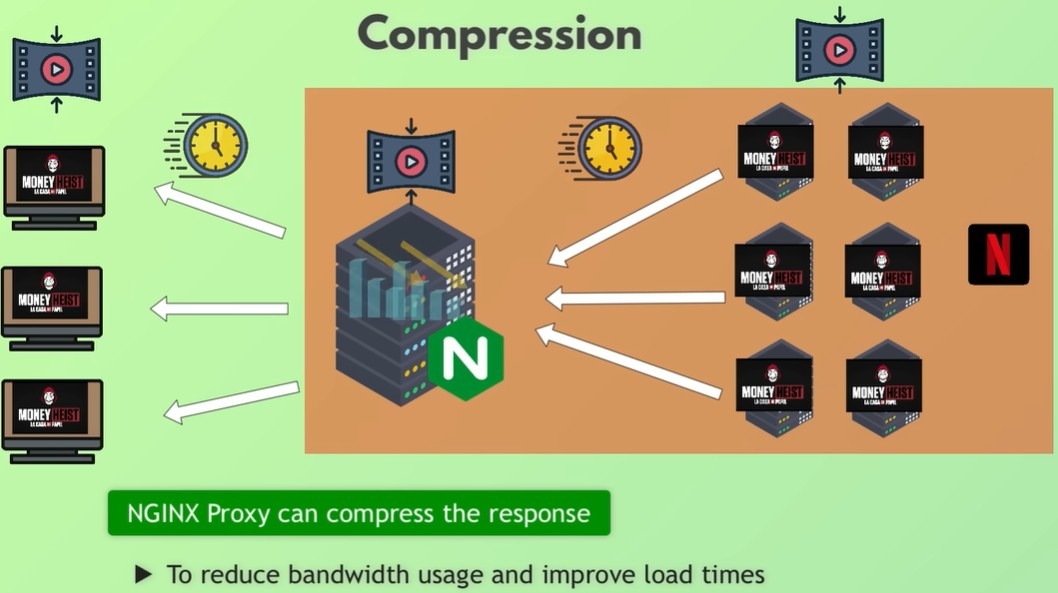

Сжатие: представь Netflix вечером

Кстати, Netflix действительно использует Nginx.

Представь вечер потоковый сервис выпускает новую серию. Миллионы пользователей включают Netflix одновременно.

Nginx должен отправить огромные видеофайлы миллионам людей.

Это колоссальная нагрузка на интернет-каналы.

Решение? Компрессия.

Nginx умеет сжимать:

-

большие изображения,

-

видеофрагменты,

-

тяжёлые файлы

Это экономит трафик и ускоряет доставку.

Плюс — Nginx может отправлять файлы частями, чтобы ты мог начать смотреть, пока остальные части догружаются.

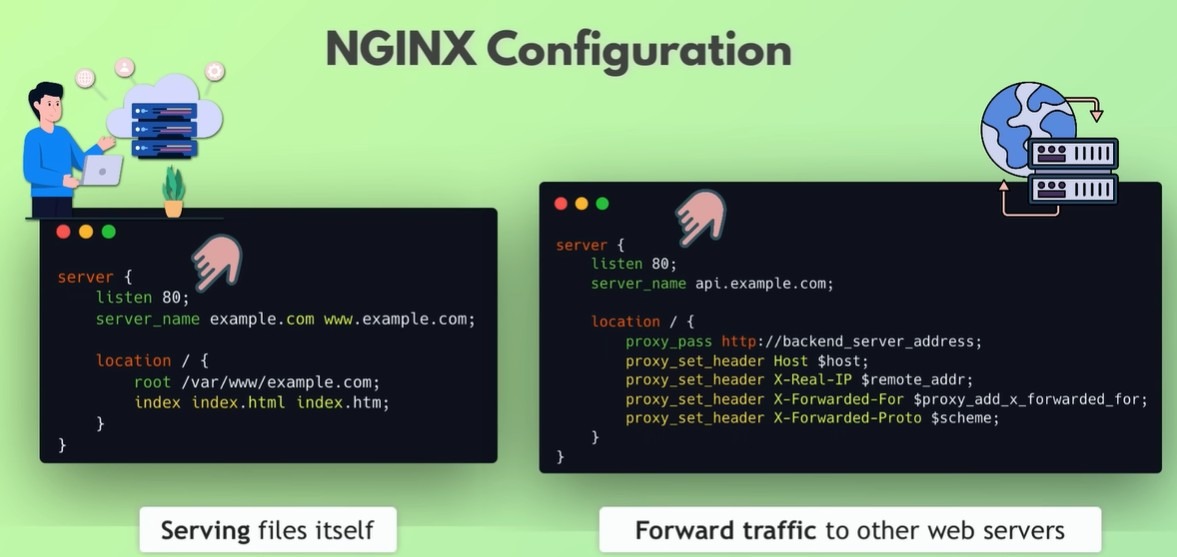

Конфигурация Nginx: как он понимает, что делать

Вся магия Nginx настраивается через конфигурационный файл с директивами:

-

в каком режиме работать — веб-сервер или прокси,

-

какие порты использовать,

-

где хранить кэш,

-

где лежат SSL-сертификаты,

-

куда перенаправлять трафик,

-

как балансировать нагрузку,

-

какие файлы отдавать,

-

какие маршруты обрабатывать.

Примеры настроек:

-

обычный веб-сервер на порту 80,

-

редирект HTTP→HTTPS,

-

HTTPS-сервер на порту 443 с сертификатами,

-

балансировка нагрузки между бэкенд-серверами,

-

настройки кэширования с TTL.

Конфигурация гибкая, подробная и простая — именно поэтому Nginx стал настолько популярным.

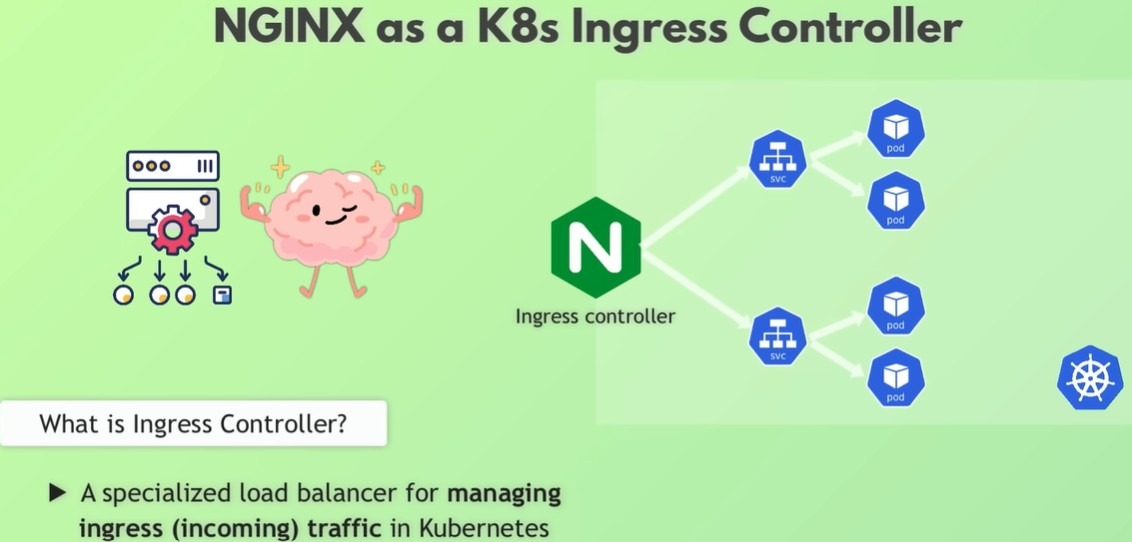

Nginx в мире контейнеров: Kubernetes Ingress Controller

Сегодня Nginx — важнейшая часть экосистемы Kubernetes.

В Kubernetes Nginx часто используется как Ingress Controller — по сути, прокси и балансировщик внутри кластера.

Механика та же:

-

получает запросы первым,

-

решает куда отправить,

-

маршрутизирует по нужным сервисам.

Например:

-

/cart→ microservice Cart -

/payment→ Payment service -

/profile→ User profile service

Публичный трафик принимает уже не Nginx, а облачный балансировщик (например, AWS ELB).

Он передаёт запросы внутрь кластера Nginx-Ingress — это добавляет слой безопасности.

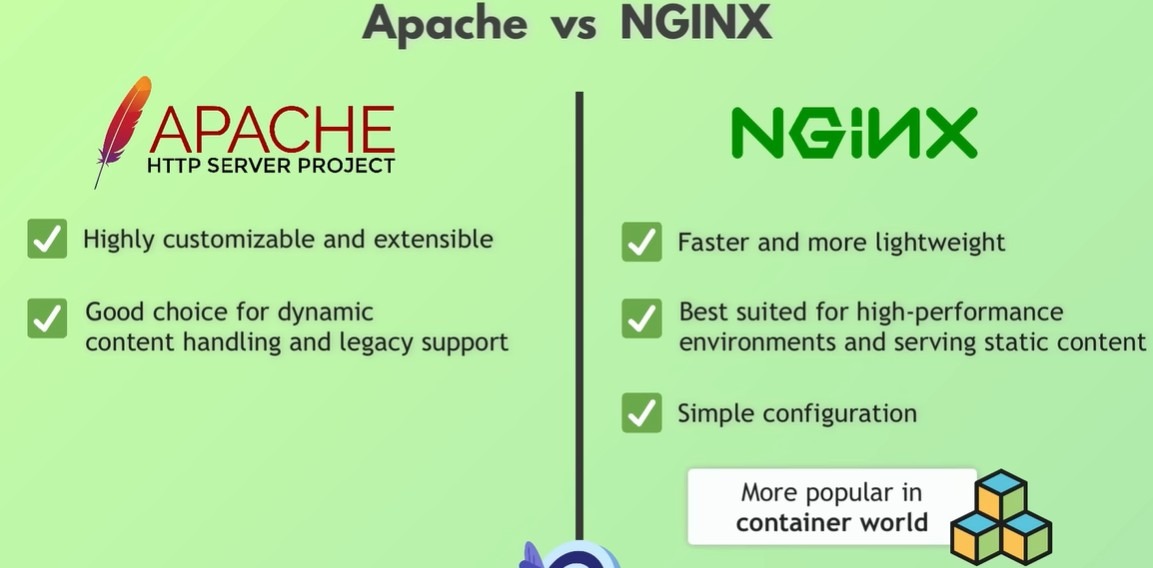

А как же Apache? В чём разница?

Apache был стандартом до появления Nginx. Он умел всё то же самое.

Но Nginx выиграл благодаря:

-

скорости,

-

лёгкости,

-

эффективности со статикой,

-

удобной конфигурации,

-

популярности в контейнерном мире.

Поэтому он стал де-факто стандартом для высоконагруженных систем.

Итог

Теперь у тебя полная и понятная картина Nginx:

-

веб-сервер,

-

прокси,

-

балансировщик нагрузки,

-

система кэширования,

-

защитный слой,

-

компрессор данных,

-

Kubernetes Ingress Controller.

Всё в одном компактном и очень быстром инструменте.